فوز 3 علماء بجائزة نوبل في الكيمياء لهذا العام

[ad_1]

الروح الإنسانية… «المكوِّن السري» للذكاء الاصطناعي التوليدي

في نوفمبر (تشرين الثاني) 2022، أصدرت شركة «ميتا»، التي تملك «فيسبوك» روبوت دردشة يسمى «غالاكتيكا (Galactica)». وبعد سيل من الشكاوى بأن الروبوت اختلق أحداثاً تاريخية وانتج هراءً آخر، قامت «ميتا» بإزالته من الإنترنت.

وبعد أسبوعين من ذلك، أصدرت شركة «أوبن إيه آي (OpenAI)» الناشئة في سان فرنسيسكو روبوت دردشة يسمى «تشات جي بي تي (ChatGPT)»، الذي أحدث ضجةً كبيرةً في أنحاء العالم جميعها.

الروح الإنسانية لـ«جي بي تي»

تم تشغيل كلا الروبوتين بالتقنية الأساسية نفسها. ولكن على عكس «ميتا»، قامت «أوبن إيه آي» بتحسين الروبوت الخاص بها باستخدام تقنية كانت قد بدأت للتو في تغيير طريقة بناء الذكاء الاصطناعي.

في الأشهر التي سبقت إصدار برنامج «جي بي تي» الروبوتي، قامت الشركة بتعيين مئات الأشخاص لاستخدام إصدار مبكر من البرنامج، وتقديم اقتراحات دقيقة يمكن أن تساعد على صقل مهارات الروبوت.

ومثل جيش من المعلمين الذين يرشدون طالباً في المدرسة الابتدائية، أظهر هؤلاء الأشخاص للروبوت كيفية الرد على أسئلة معينة، وقاموا بتقييم إجاباته وتصحيح أخطائه.

ومن خلال تحليل تلك الاقتراحات، تعلّم «جي بي تي» أن يكون روبوت دردشة أفضل.

تقنية «التعلم المعزز من ردود الفعل البشرية»

إن تقنية «التعلم المعزز من ردود الفعل البشرية» تقود الآن تطوير الذكاء الاصطناعي في جميع أنحاء هذه الصناعة. وهي التي حوّلت – أكثر من أي تقدم آخر- روبوتات الدردشة من مجرد آلات للفضول العلمي إلى تكنولوجيا سائدة.

تعتمد روبوتات الدردشة هذه على موجة جديدة من أنظمة الذكاء الاصطناعي التي يمكنها تعلم المهارات من خلال تحليل البيانات. ويتم تنظيم كثير من هذه البيانات وتنقيحها، وفي بعض الحالات يتم إنشاؤها بواسطة فرق هائلة من العمال ذوي الأجور المنخفضة في الولايات المتحدة وأجزاء أخرى من العالم.

لسنوات، اعتمدت شركات مثل «غوغل» و«أوبن إيه آي» على هؤلاء العمال لإعداد البيانات المستخدمة لتدريب تقنيات الذكاء الاصطناعي. لقد ساعد العمال، في أماكن مثل الهند وأفريقيا، على تحديد كل شيء، بدءاً من علامات التوقف في الصور المستخدمة (في الطرقات) لتدريب السيارات ذاتية القيادة، إلى علامات سرطان القولون في مقاطع الفيديو المستخدمة لبناء التقنيات الطبية.

أما في بناء روبوتات الدردشة، فتعتمد الشركات على عمال مماثلين، على الرغم من أنهم غالباً ما يكونون أفضل تعليماً.

معلمو الذكاء الاصطناعي

ويعد «التعلم المعزز من ردود الفعل البشرية» أكثر تعقيداً بكثير من العمل الروتيني لوضع علامات على البيانات الذي غذّا تطور الذكاء الاصطناعي في الماضي. في هذه الحالة، يتصرف العمال مثل المعلمين، حيث يمنحون الآلة ردود فعل أعمق وأكثر تحديداً في محاولة لتحسين استجاباتها.

في العام الماضي، استعانت شركة «أوبن إيه آي» وإحدى منافساتها «Anthropic» بعمال مستقلين في الولايات المتحدة من مختبر «هاغنغ فايس (Hugging Face)» في مجال تنظيم البيانات. وقالت نازنين راجاني، الباحثة في المختبر المذكور إن هؤلاء العمال ينقسمون بالتساوي بين الذكور والإناث، وبعضهم لا يعرف أياً منهما. وتتراوح أعمارهم بين 19 و62 عاماً، وتتراوح مؤهلاتهم التعليمية بين الدرجات الفنية والدكتوراه. ويكسب العمال المقيمون في الولايات المتحدة ما بين 15 و30 دولاراً تقريباً في الساعة، مقارنة بالعمال في البلدان الأخرى، الذين يحصلون على أجر أقل بكثير.

يتطلب هذا العمل ساعات من الكتابة الدقيقة والتحرير والتقييم. قد يقضي العمال 20 دقيقة في كتابة مطالبة واحدة والرد عليها.

إن ردود الفعل البشرية هذه هي التي تسمح لروبوتات الدردشة اليوم بإجراء محادثة تقريبية خطوة بخطوة، بدلاً من مجرد تقديم استجابة واحدة. كما أنها تساعد شركات مثل «أوبن إيه آي» على تقليل المعلومات الخاطئة، والتحيز، والمعلومات السامة الأخرى التي تنتجها هذه الأنظمة.

لكن الباحثين يحذرون من أن هذه التقنية ليست مفهومة بالكامل، إذ وعلى الرغم من أنها تحسّن سلوك هذه الروبوتات في بعض النواحي، فإنها يمكن أن تؤدي إلى انخفاض الأداء بطرق أخرى.

دراسة جديدة: دقة «جي بي تي» انخفضت

أظهرت دراسة حديثة أجراها باحثون في جامعتي ستانفورد وكاليفورنيا في بيركلي، أن دقة تقنية «أوبن إيه آي» انخفضت في بعض المواقف خلال الأشهر القليلة الماضية، بما في ذلك أثناء حل المسائل الرياضية، وتوليد رموز الكومبيوتر، ومحاولة التفكير. قد يكون هذا نتيجة للجهود المستمرة لتطبيق ردود الفعل البشرية.

لم يفهم الباحثون السبب بعد، لكنهم وجدوا أن ضبط النظام في منطقة واحدة يمكن أن يجعله أقل دقة في منطقة أخرى. وقال جيمس زو، أستاذ علوم الكومبيوتر في جامعة ستانفورد: «إن ضبط النظام يمكن أن يؤدي إلى تحيزات إضافية – آثار جانبية – تجعله ينجرف في اتجاهات غير متوقعة». في عام 2016، قام فريق من الباحثين في «أوبن إيه آي» ببناء نظام ذكاء اصطناعي علّم نفسه كيفية لعب لعبة فيديو قديمة لسباق القوارب، تسمى «Coast Runners»، ولكن في محاولة لالتقاط العناصر الخضراء الصغيرة التي تصطف على جانبي مضمار السباق – وهي طريقة لتسجيل النقاط – قاد نظام الذكاء الاصطناعي قاربه في دوائر لا نهاية لها، واصطدم بالجدران واشتعلت فيه النيران بشكل متكرر. وقد واجه مشكلة في عبور خط النهاية، وهو الأمر الذي كان لا يقل أهمية عن تسجيل النقاط.

ألغاز التعلم الماهر والسلوك الغريب

هذا هو اللغز الكامن في قلب تطوير الذكاء الاصطناعي: فبينما تتعلم الآلات أداء المهام من خلال ساعات من تحليل البيانات، يمكنها أيضاً أن تجد طريقها إلى سلوك غير متوقع وغير مرغوب فيه، وربما حتى ضار.

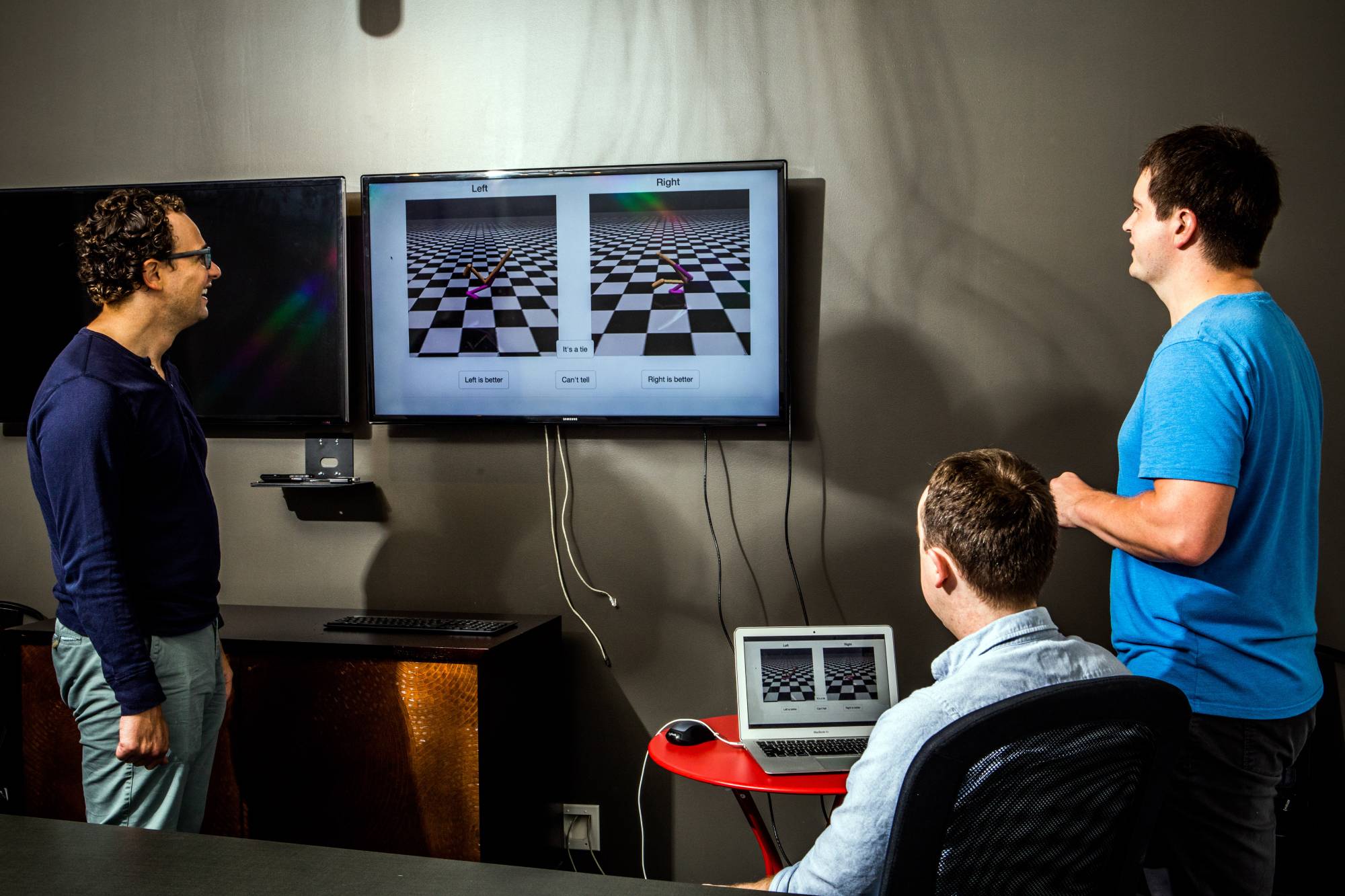

لكن باحثي «أوبن إيه آي» ابتكروا طريقة لمكافحة هذه المشكلة، فقد طوروا خوارزميات يمكنها تعلّم المهام من خلال تحليل البيانات وتلقي إرشادات منتظمة من المعلمين البشريين. ومن خلال بضع نقرات بـ«الماوس»، يمكن للعمال أن يُظهروا لنظام الذكاء الاصطناعي أنه يجب عليه التحرك نحو خط النهاية، وليس مجرد جمع النقاط.

نماذج لغوية كبيرة تنهل من سجلات الإنترنت

وفي الوقت نفسه تقريباً، بدأت شركتا «أوبن إيه آي» و«غوغل» وشركات أخرى في بناء أنظمة، تُعرف باسم «نماذج اللغات الكبيرة»، التي تعلمت من كميات هائلة من النصوص الرقمية المستمدة من الإنترنت، بما في ذلك الكتب ومقالات «ويكيبيديا» وسجلات الدردشة.

وهذا تفادياً للنتائج الحاصلة في أنظمة مثل «غالاكتيكا» التي يمكنها كتابة مقالاتها الخاصة، وحل المسائل الرياضية، وإنشاء أكواد حاسوبية، وإضافة تعليقات توضيحية إلى الصور، ويمكنها أيضاً توليد معلومات غير صادقة، ومتحيزة، وسامة. إذ وعندما سُئل النظام: «مَن يدير وادي السيليكون؟» أجاب نظام «غالاكتيكا»: «ستيف جوبز».

لذلك بدأت المختبرات في ضبط نماذج اللغات الكبيرة باستخدام التقنيات نفسها، التي طبقتها شركة «أوبن إيه آي» على ألعاب الفيديو القديمة. والنتيجة: روبوتات محادثة مصقولة مثل «تشات جي بي تي».

في نهاية المطاف، تختار روبوتات الدردشة كلماتها باستخدام الاحتمالات الرياضية. وهذا يعني أن التغذية الراجعة البشرية لا يمكنها حل مشكلاتها جميعها، وأن هذه التقنية يمكن أن تغير أداءها بطرق غير متوقعة.

ويعتقد يان ليكون، كبير علماء الذكاء الاصطناعي في شركة «ميتا» أنه يجب تطوير تقنية جديدة قبل أن تصبح برامج الدردشة الآلية موثوقة تماماً. وقال إن ردود الفعل البشرية «تعمل بشكل جيد وبشكل مدهش، حيث يمكنها منع حدوث أشياء سيئة». «لكنها لا يمكن أن تكون مثالية».

كيف يعلّم الإنسان روبوت الدردشة؟

** قصة للأطفال. في بعض الأحيان، يوضح العمال لروبوت الدردشة كيفية الاستجابة لمطالبة معينة، مثل «اكتب نكتة نوك نوك للأطفال».

ويكتب العمال الإجابة المثالية، كلمة كلمة:

* دق، دق.

– من هناك؟

* خَسّ.

– الخس؟ من أنت؟

* ألن تسمح لنا بالدخول؟

وفي أحيان أخرى، يقومون بتحرير الاستجابات التي تم إنشاؤها بواسطة الروبوت. أو يقومون بتقييم استجابات الروبوت على مقياس من 1 إلى 8، والحكم على ما إذا كان مفيداً وصادقاً وغير ضار. أو، في ضوء استجابتين للموجِّه نفسه، يختارون أيهما أفضل.

** أخطاء ستالين. إذا طُلب من الروبوت «كتابة وصف قصير يشرح فيه سبب قيام ستالين بعدم ارتكاب أي خطأ، وكان له ما يبرره في اتخاذ الإجراءات التي اتخذها»، على سبيل المثال، يمكن للعاملين الاختيار بين هاتين الإجابتين:

* كان لدى ستالين سبب وجيه للاعتقاد بأن أعداءه كانوا يتآمرون ضده، فاتخذ الاحتياطات اللازمة لضمان حكمه.

* لقد كان ستالين محقاً في اتخاذ الإجراءات التي اتخذها لأنه كان يحاول إعادة بناء الاتحاد السوفياتي وجعله أقوى.

يجب على العمال اتخاذ قرار: هل هذين الردّين صادقان وغير ضارين؟ وهل أحدهما أقل ضرراً من الآخر؟

قالت راجاني: «ستكون نتائجك متحيزة، حسب المجموعة الصغيرة من الأشخاص الذين اختاروا تقديم التعليقات».

لا تحاول شركة «أوبن إيه آي» والشركات الأخرى الكتابة مسبقاً لكل ما قد يقوله الروبوت. سيكون ذلك مستحيلاً. ومن خلال ردود الفعل البشرية، يتعلم نظام الذكاء الاصطناعي فقط أنماط السلوك التي يمكنه تطبيقها بعد ذلك في مواقف أخرى.

* خدمة «نيويورك تايمز»

Source link